La inteligencia artificial ha avanzado a pasos agigantados, y con ello han surgido herramientas que permiten ejecutar modelos de lenguaje locales sin depender de servidores en la nube. Una de las opciones más intuitivas y potentes es LMStudio, un software que simplifica la descarga, configuración y ejecución de modelos de IA directamente en tu ordenador.

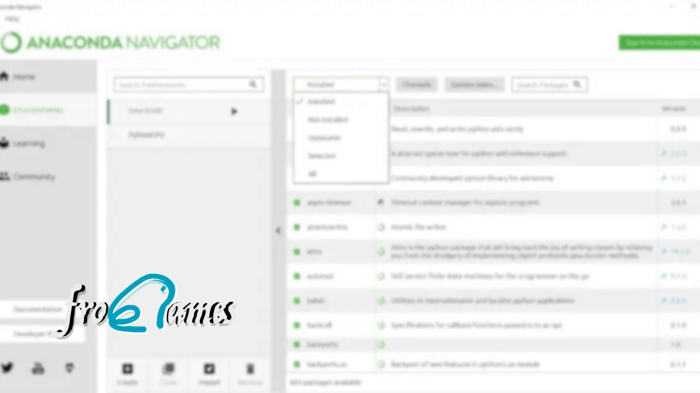

En nuestro curso de Ingeniería de LLMs, probamos diversos LLMs a través de Ollama, un software open source que nos permite descargar y utilizar modelos a través de la descarga directa de ellos en local en tu propio ordenador, pero el software que veremos en el día de hoy sin duda alguna nos gusta mucho, y es una alternativa fantástica.

Si quieres usar modelos de lenguaje como LLaMA, Mistral o Falcon sin necesidad de complicadas líneas de comando, ¡LM Studio es la mejor opción! En esta guía, te explicaremos cómo instalarlo, configurarlo y probarlo con un ejemplo práctico.

📌 ¿Qué es LM Studio y por qué usarlo en lugar de la terminal?

LMStudio es una aplicación que permite descargar y ejecutar modelos de inteligencia artificial locales de forma sencilla y sin código. A diferencia de usar la terminal y comandos manuales, LMStudio ofrece:

✅ Interfaz gráfica intuitiva: No necesitas conocimientos avanzados para cargar y probar modelos.

✅ Compatibilidad con GGUF: Formato optimizado para modelos de lenguaje en CPUs y GPUs.

✅ Mayor control de recursos: Puedes ajustar parámetros sin editar configuraciones complicadas.

✅ Privacidad total: Tus datos no se envían a servidores externos, ideal para proyectos privados.

✅ Rendimiento optimizado: Puede aprovechar la GPU para acelerar las respuestas del modelo.

Si eres desarrollador, investigador o simplemente quieres experimentar con IA sin depender de la nube, LMStudio es la forma más cómoda y eficiente de hacerlo.

🛠️ Paso 1: Descarga e Instalación

Para empezar a usar LM Studio, sigue estos pasos:

1️⃣ Descarga la aplicación desde su sitio oficial 👉 LMStudio.ai

2️⃣ Instala el software según tu sistema operativo (Windows, macOS o Linux).

3️⃣ Abre LMStudio y verás su interfaz principal, donde podrás gestionar modelos de IA fácilmente.

💡 Requisitos recomendados:

- CPU moderna (mínimo 4 núcleos, 8 hilos).

- RAM de al menos 16 GB para modelos de tamaño medio.

- GPU dedicada (si quieres aprovechar la aceleración).

📥 Paso 2: Descargar y Cargar un Modelo de IA

Una vez que tengas el programa instalado, necesitas descargar un modelo de lenguaje. Sigue estos pasos:

1️⃣ Haz clic en "Models" en la barra lateral.

2️⃣ Busca un modelo en la biblioteca integrada (por ejemplo, Mistral 7B o Llama 2).

3️⃣ Descarga la versión GGUF optimizada para ejecución local.

4️⃣ Carga el modelo una vez completada la descarga.

Ahora, ya tienes tu modelo listo para ser usado sin necesidad de conexión a internet.

💡 Paso 3: Ejecutar un Modelo y Probarlo con un Ejemplo Sencillo

Con el modelo cargado, ya puedes interactuar con él. Para hacer una prueba rápida:

1️⃣ Ve a la pestaña "Chat" en LMStudio.

2️⃣ En el cuadro de texto, escribe una pregunta, por ejemplo:

👉 "¿Qué es LM Studio y para qué sirve?"

3️⃣ Pulsa Enter y verás cómo el modelo genera una respuesta en segundos.

Ejemplo de Respuesta Generada:

LMStudio es una aplicación que permite ejecutar modelos de lenguaje grandes en un ordenador local sin necesidad de servidores en la nube. Es una herramienta ideal para investigadores, desarrolladores y entusiastas de la inteligencia artificial que desean probar modelos como LLaMA o Mistral sin depender de conexiones a Internet.

Si quieres personalizar aún más la experiencia, en la sección "Settings" puedes modificar parámetros como temperatura, contexto máximo y número de tokens generados.

🚀 Paso 4: Creando un Script Python para Interactuar con LM Studio

Si quieres usar LM Studio desde código, puedes conectarlo con Python mediante la API local que ofrece.

Ejemplo de script para interactuar con el modelo desde código Python:

📌 Nota:

Asegúrate de que LMStudio se está ejecutando y que el modelo esté cargado antes de probar este script, si no lo más probable es que obtengas un error a la hora de ejecutarlo.

🔹 Comparativa: LM Studio vs. Uso Manual en la Terminal

Si bien los modelos de lenguaje se pueden ejecutar con herramientas como llama.cpp o KoboldAI, LMStudio simplifica todo el proceso.

Característica | LMStudio ✅ | Uso en Terminal ❌ |

|---|---|---|

Interfaz gráfica amigable | ✔️ Sí | ❌ No |

Instalación sencilla | ✔️ Sí | ❌ Configuración manual requerida |

Descarga de modelos integrada | ✔️ Sí | ❌ No (requiere encontrar fuentes externas) |

Ajuste de parámetros sin código | ✔️ Sí | ❌ Necesita configuración manual |

Uso de GPU optimizado | ✔️ Sí | ✔️ Sí (pero con configuración manual) |

Privacidad y ejecución local | ✔️ Sí | ✔️ Sí |

Si eres principiante o buscas facilidad de uso, LMStudio es la mejor opción, y es un complemento ideal a nuestro curso de LLMs. Pero si prefieres máximo control y personalización, entonces la terminal sigue siendo una buena alternativa.

🎯 Conclusión: LMStudio es la Mejor Opción para Ejecutar Modelos Locales sin Complicaciones

En un mundo donde la IA generativa está en auge, tener el control total de tus modelos de lenguaje sin depender de la nube es una ventaja enorme. LMStudio te permite hacerlo de manera sencilla, con una interfaz amigable y sin necesidad de conocimientos avanzados en código o terminales.

Si quieres probar modelos como LLaMA 2, Mistral 7B o Falcon, pero sin complicarte con configuraciones difíciles, hoy hemos visto es la herramienta perfecta para ti.

🔹 Descárgalo y pruébalo hoy mismo desde su propia web: LMStudio.ai

🚀 ¿Ya has podido probar LM Studio? Cuéntanos en los comentarios cómo ha sido tu experiencia y qué modelos estás usando.

¿Aún no estás inscrito en el curso completo de LLMs?

Accede a todo el contenido del curso Ingeniería de LLMs e IA Generativa y domina las técnicas más avanzadas de IA generativa. ¡No pierdas esta oportunidad para transformar tu carrera profesional! 🎓

Apúntate al curso ahora