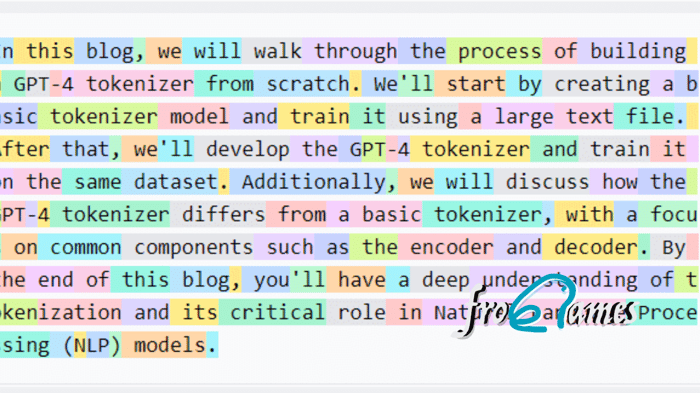

En el contexto de trabajar con modelos de lenguaje grandes (LLMs), entender cómo el texto se mapea a tokens es crucial para optimizar el rendimiento del modelo y gestionar las limitaciones de entrada. Métodos como encode, decode y convert_ids_to_tokens permiten explorar y manipular el proceso de tokenización. Aquí te explico cómo funciona cada uno y su relevancia:

1. Método encode 📜

El método encode convierte una cadena de texto en una secuencia de tokens (generalmente representados por sus identificadores) que el modelo puede procesar. Cada token generalmente corresponde a una palabra, subpalabra o carácter, dependiendo del tokenizador utilizado.

Uso:

Esto devolverá una lista de identificadores de tokens que representan el texto de entrada.

Relevancia:

Permite entender cómo el modelo percibe el texto. Por ejemplo, la frase "Hola, ¿cómo estás?" puede descomponerse en tokens individuales como["Hola", ",", "¿", "cómo", "estás", "?"]o incluso subpalabras, dependiendo del vocabulario del tokenizador.

2. Método decode 🔄

El método decode convierte una secuencia de identificadores de tokens nuevamente en texto legible. Esto es útil para interpretar los tokens generados por el modelo, especialmente cuando se trabaja con salidas del modelo.

Uso:

Esto devolverá la cadena de texto original a partir de la secuencia de identificadores de tokens.

Relevancia:

La funcióndecodees importante cuando se desea interpretar las salidas del modelo, como en tareas de generación de texto. También ayuda a identificar cómo la tokenización puede alterar el texto (por ejemplo, separando palabras en subpalabras o añadiendo tokens especiales).

3. Método convert_ids_to_tokens 🔢➡️🔠

El método convert_ids_to_tokens mapea los identificadores de los tokens a sus cadenas correspondientes. Esto te da acceso directo a los tokens específicos que corresponden a cada identificador de token.

Uso:

Esto devolverá una lista de cadenas de tokens, por ejemplo:

['[CLS]', 'hola', 'mundo'].Relevancia:

Este método permite ver los tokens reales que se usaron para representar el texto. Es útil para depurar y entender cómo se representan palabras o subpalabras específicas en el vocabulario del modelo.

Curiosidades de la Tokenización 🧐

Tokenización de Subpalabras: Muchos tokenizadores utilizan tokenización de subpalabras (por ejemplo, Byte Pair Encoding, WordPiece), que descompone palabras raras en partes más pequeñas (subpalabras). Por ejemplo, "desafortunado" podría tokenizarse como

['des', '##afortunado'].Tokens Especiales: Los tokenizadores a menudo insertan tokens especiales como

[CLS],[SEP]o[PAD]para marcar el comienzo, la separación o el relleno en las secuencias. Estos tokens no forman parte del "texto natural", pero son esenciales para el procesamiento del modelo.Variaciones en la Codificación de Texto: El proceso de tokenización puede variar significativamente entre diferentes modelos, ya que cada modelo puede utilizar su propio vocabulario y reglas de tokenización. Por ejemplo, BERT y GPT-3 usan métodos de tokenización diferentes, lo que puede afectar la forma en que manejan el texto.

Al usar encode, decode y convert_ids_to_tokens, puedes obtener una visión más profunda de cómo los LLMs procesan y entienden el texto, así como las peculiaridades inherentes a la tokenización. Este entendimiento es crucial para optimizar el manejo de entradas y salidas para asegurar el mejor rendimiento del modelo.

¿Aún no estás inscrito en el curso completo?

Accede a todo el contenido del curso Ingeniería de LLMs e IA Generativa y domina las técnicas más avanzadas de IA generativa. ¡No pierdas esta oportunidad para transformar tu carrera profesional! 🚀

Apúntate al curso ahoraY ahora que ya dominas los tokens 🧐

Ahora que hemos explorado cómo funcionan los tokenizers y cómo los textos se transforman en tokens, es el momento perfecto para profundizar en el proceso de entrenamiento de un modelo de lenguaje grande (LLM). Con este conocimiento, comprenderemos mejor cómo los datos se preparan y procesan antes de ser utilizados en el entrenamiento. Te invitamos a leer el artículo completo en el post, donde detallamos cómo empaquetar y encriptar los textos para subirlos a Hugging Face y afinar el modelo con QLoRA. Este paso es esencial para avanzar en el desarrollo de modelos más eficientes y especializados.