¿Quieres aprender ciencia de datos desde cero y no sabes por dónde empezar? Todo lo que necesitas lo tienes aquí: fundamentos, herramientas, técnicas avanzadas y presentación de un portafolio.

La ciencia de datos está considerada como uno de los campos más estratégicos y dinámicos en el ámbito tecnológico moderno. Ya que es esencial para tomar decisiones informadas y crear sistemas inteligentes en prácticamente todas las industrias. Desde la optimización de procesos empresariales hasta el desarrollo de tecnologías avanzadas en salud y educación, la capacidad para analizar y interpretar datos masivos se ha convertido en una habilidad indispensable en la era digital.

Este artículo está diseñado para guiar a los entusiastas que desean adentrarse en el mundo de la ciencia de datos desde cero. Abarcaremos desde los fundamentos matemáticos y estadísticos hasta las herramientas y tecnologías más avanzadas que están moldeando el futuro del análisis de datos. Nuestra entrada está dirigida a quienes buscan comprender los principios básicos. Y también a aquellos interesados en profundizar en técnicas sofisticadas como el aprendizaje automático y la inteligencia artificial.

Fundamentos: Ciencia de Datos desde Cero

Para adentrarse en la ciencia de datos desde cero, es esencial comprender ciertos fundamentos básicos que constituyen la columna vertebral de cualquier análisis avanzado. Estos cimientos incluyen las matemáticas y estadística, la programación y el manejo de bases de datos. Cada una de estas áreas proporciona las herramientas necesarias para extraer significado de grandes conjuntos de datos y para desarrollar soluciones efectivas a problemas complejos.

1. Matemáticas y Estadística

Las matemáticas y la estadística son fundamentales en la ciencia de datos. Ya que proporcionan el marco teórico para casi todos los métodos de análisis y modelado de datos. Un buen científico de datos debe tener una sólida comprensión de la probabilidad, ya que es determinante para entender la incertidumbre de los modelos y las predicciones. La estadística inferencial, que permite hacer generalizaciones a partir de muestras de datos y tomar decisiones, es otro pilar importante. Por otro lado, conceptos como las pruebas de hipótesis, intervalos de confianza y regresión lineal y logística deben ser dominados. Además, métodos de optimización como la minimización de funciones de coste son esenciales para algoritmos de aprendizaje automático, donde se busca optimizar el rendimiento de los modelos.

2. Programación

En el mundo de la ciencia de datos la programación es una habilidad indispensable. Python y R son los lenguajes de programación más populares debido a su simplicidad y poderosas librerías diseñadas específicamente para análisis de datos. Python, por ejemplo, es valorado por su sintaxis clara y el amplio soporte de librerías como Pandas para la manipulación de datos, NumPy para operaciones numéricas, y Matplotlib para la visualización de datos. R, por otro lado, es muy apreciado en estadística y puede ser más intuitivo para los usuarios con un fuerte trasfondo estadístico. La capacidad de escribir código limpio y eficiente, junto con una comprensión sólida de estructuras de datos y algoritmos, son clave para procesar y analizar grandes volúmenes de datos de manera efectiva.

3. Bases de Datos

El manejo de bases de datos es otra habilidad crítica para cualquier científico de datos. El conocimiento de SQL, el lenguaje estándar para gestionar y recuperar datos de bases de datos relacionales, es fundamental. SQL permite a los usuarios extraer, transformar y cargar datos (ETL), una parte vital del proceso de preparación de datos antes del análisis. Además, con el crecimiento de los datos no estructurados, las bases de datos NoSQL como MongoDB y Cassandra ofrecen alternativas flexibles para almacenar y manejar tipos de datos variados. Entender cuándo y cómo utilizar estas herramientas en situaciones aplicables es indispensable para manejar eficientemente grandes datasets.

Herramientas y Tecnologías Esenciales

Para dominar la ciencia de datos desde cero, debes familiarizarte con una variedad de herramientas y tecnologías que permiten la manipulación, análisis y visualización eficaz de los datos. Este arsenal de herramientas incluye librerías y frameworks específicos para programación, plataformas avanzadas para manejar grandes volúmenes de datos y sistemas sofisticados para la visualización. Cada una de ellas desempeña un papel vital en la transformación de los datos crudos en insights accionables y en la construcción de soluciones basadas en datos.

1. Librerías y Frameworks

Python y R, como se mencionó anteriormente, son fundamentales para cualquier científico de datos por su capacidad de programación. Así como por el soporte de numerosas librerías que simplifican las tareas complejas de análisis de datos. En Python librerías como Pandas son esenciales para la manipulación y preparación de datos, permitiendo operaciones complejas de limpieza y transformación de datos con facilidad. NumPy es imprescindible para cualquier trabajo que involucre operaciones matemáticas complejas, especialmente con arrays multidimensionales. Finalmente, SciPy complementa a NumPy con herramientas y algoritmos adicionales para cálculo numérico.

Para el modelado estadístico, scikit-learn ofrece un acceso robusto y fácil de usar a una amplia gama de algoritmos de aprendizaje automático, desde la regresión y clasificación hasta el clustering y la reducción de dimensionalidad. Estas herramientas son determinantes para analizar y construir modelos predictivos eficaces.

2. Visualización de Datos

La visualización es una parte integral del análisis de datos, proporcionando una manera de comunicar efectivamente incluso los conceptos más complejos de forma comprensible. Matplotlib y Seaborn son herramientas de visualización en Python que ofrecen funcionalidades extensas para crear gráficos estáticos, animados e interactivos. Para visualizaciones más avanzadas y dashboards interactivos, herramientas como Tableau y Power BI permiten a los usuarios visualizar datos y realizar análisis a través de interfaces intuitivas y dinámicas.

3. Plataformas de Big Data

Cuando los conjuntos de datos crecen en tamaño y complejidad, las herramientas tradicionales pueden quedarse cortas. Aquí es donde entran en juego las plataformas de Big Data como Apache Hadoop y Apache Spark. Hadoop utiliza un sistema de archivos distribuido (HDFS) para almacenar datos a través de múltiples máquinas y procesar esos datos en paralelo utilizando MapReduce. Esto permite manejar petabytes de datos distribuidos a lo largo de miles de servidores eficientemente. Por otro lado, Apache Spark es conocido por su velocidad y capacidad para realizar operaciones de datos en memoria. Lo que lo hace particularmente útil para tareas que requieren una alta velocidad de procesamiento y un acceso rápido a los datos, como el procesamiento en tiempo real y el aprendizaje automático.

Machine Learning y Algoritmos Avanzados

El machine learning es un componente esencial para aprender ciencia de datos desde cero, proporcionando la capacidad de predecir, clasificar y tomar decisiones basadas en datos. Una comprensión profunda de los algoritmos de ML y sus aplicaciones es clave para diseñar modelos efectivos, innovar y avanzar en la resolución de problemas complejos. En este apartado veremos los conceptos clave del aprendizaje supervisado y no supervisado, las redes neuronales y el aprendizaje profundo, así como la evaluación de modelos.

1. Supervisado vs. No Supervisado

En el aprendizaje supervisado los modelos se entrenan utilizando un conjunto de datos etiquetado, lo que significa que cada entrada de datos tiene una salida correspondiente conocida. Ejemplos comunes incluyen la regresión lineal y logística para problemas de predicción y clasificación, respectivamente. Los algoritmos supervisados son ideales para aplicaciones donde las relaciones históricas entre las características de los datos y los resultados deseados son claras y bien definidas.

Por otro lado, el aprendizaje no supervisado se utiliza con datos que no están etiquetados, es decir, no se conoce la salida. Este enfoque es útil para descubrir estructuras ocultas en los datos, como grupos o patrones comunes. Algoritmos como K-means para clustering y PCA (Análisis de Componentes Principales) para reducción de dimensionalidad son técnicas fundamentales en esta categoría. Estos métodos son especialmente valiosos para la exploración de datos y para situaciones donde se desconocen las categorías o se desea identificar nuevas relaciones en los datos.

2. Redes Neuronales y Aprendizaje Profundo

Las redes neuronales son un paso avanzado en el machine learning. Y están inspiradas en las redes neuronales biológicas. Comprenden capas de nodos interconectados que procesan datos de manera secuencial, lo que permite aprender y modelar relaciones complejas y no lineales. El aprendizaje profundo, una subcategoría de las redes neuronales, utiliza estructuras con muchas capas (conocidas como redes neuronales profundas) para aprender de grandes cantidades de datos. Frameworks como TensorFlow y Keras han hecho accesible la implementación de estos modelos complejos, permitiendo aplicaciones en reconocimiento de imágenes, procesamiento del lenguaje natural y mucho más.

3. Evaluación de Modelos

Una vez que un modelo ha sido entrenado, debemos evaluar su eficacia y precisión. La validación cruzada es una técnica utilizada para asegurar que el modelo es robusto y funciona bien en datos no vistos. Esto implica dividir el conjunto de datos en múltiples subconjuntos y entrenar el modelo en varias combinaciones de estos subconjuntos. Lo que ayuda a evitar el sobreajuste y asegura que el modelo sea generalizable. Otras técnicas como las curvas ROC para clasificadores y el análisis de residuos para regresión también son importantes para medir la precisión y la eficacia de los modelos.

Proyectos y Construcción de un Portafolio

Una parte fundamental de la formación en ciencia de datos desde cero es la aplicación práctica de las habilidades a través de proyectos reales. Para alguien que está aprendiendo, construir un portafolio robusto con proyectos relevantes y bien documentados puede ser decisivo en la búsqueda de oportunidades laborales en este campo competitivo. Este apartado se centra en cómo desarrollar proyectos significativos, contribuir a proyectos de código abierto y presentar eficazmente estos trabajos para destacar en el mundo profesional.

1. Proyectos de Muestra

Comenzar con proyectos que reflejen problemas reales es una excelente manera de demostrar habilidades prácticas. Estos pueden variar desde análisis exploratorios de datos hasta el desarrollo de modelos predictivos complejos o sistemas de recomendación. Por ejemplo, un proyecto podría involucrar la creación de un modelo para predecir precios de viviendas basado en características como ubicación, tamaño y número de habitaciones. Otro podría ser el análisis de sentimientos de reseñas de clientes para un producto en particular, utilizando técnicas de procesamiento de lenguaje natural.

El objetivo es seleccionar proyectos que destaquen la habilidad técnica. Y que también muestren cómo se pueden aplicar estos conocimientos para resolver problemas específicos en diversas industrias. Es importante también que incluyan una buena documentación y visualización de los datos y resultados. Aspectos que son fundamentales para la comunicación efectiva de hallazgos técnicos a un público no familiarizado con el tema.

2. Contribución a Proyectos de Código Abierto

Contribuir a proyectos de código abierto es otra manera excelente de ganar experiencia práctica mientras se aporta a la comunidad. Plataformas como GitHub ofrecen una variedad de proyectos en los que los aspirantes a científicos de datos pueden colaborar. Trabajar en ellos ayuda a mejorar las habilidades de programación y análisis. Al tiempo que proporciona una visibilidad importante dentro de la comunidad de ciencia de datos.

Buscar proyectos que estén activos, que tengan una buena comunidad de colaboradores y que estén relacionados con los intereses personales puede hacer que la experiencia sea tanto enriquecedora como educativa. La participación en estos proyectos también puede ofrecer la oportunidad de aprender de desarrolladores y científicos de datos más experimentados, un recurso de gran valor en el aprendizaje técnico avanzado.

3. Consejos para Documentar y Presentar Proyectos

La documentación de un proyecto debe ser clara, concisa y detallada. Debe explicar el problema, la metodología empleada, los resultados y las conclusiones. Utilizar herramientas como Jupyter Notebook para la documentación permite integrar código, gráficos y texto en un solo documento, facilitando la comprensión y la replicabilidad de los proyectos.

Al presentar proyectos a posibles empleadores o en entrevistas, debemos destacar las habilidades técnicas utilizadas y la capacidad de aplicar estas habilidades para obtener insights y resolver problemas. Preparar una presentación que resuma el proyecto, incluyendo desafíos enfrentados y cómo se superaron, mostrará una comprensión profunda y una aplicación efectiva de las habilidades de ciencia de datos.

Aprende Ciencia de Datos desde Cero con Frogames

Con el creciente impacto y relevancia de la ciencia de datos en todos los sectores, el dominio de habilidades como la programación en Python y R, el análisis estadístico, la visualización de datos y el aprendizaje automático se ha vuelto esencial. A través de este artículo hemos visto la importancia de estas competencias y cómo pueden transformarse en herramientas poderosas para la innovación y el progreso profesional.

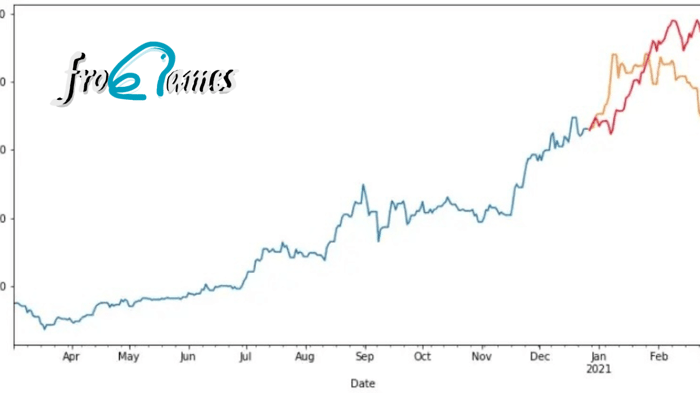

Sin embargo, dominar estas habilidades por cuenta propia puede ser un desafío casi imposible. Por este motivo los cursos estructurados y guiados marcarán la diferencia en tu aprendizaje. Frogames, bajo la dirección del experto Juan Gabriel Gomila, ofrece una ruta de aprendizaje completa y detallada en Análisis de Datos que abarca todo lo necesario para convertirte en un científico de datos competente y bien pagado.

Esta ruta incluye más de 3000 clases y 500 horas de vídeo, cubriendo desde los fundamentos hasta técnicas avanzadas en Big Data utilizando R y Python—los lenguajes de programación más demandados en el campo de la ciencia de datos. Además, contarás con recursos adicionales y acceso a una comunidad exclusiva para resolver dudas y compartir experiencias con otros estudiantes y profesores.

Frogames te proporciona una suscripción económica que permite acceder a todos los cursos de Análisis de Datos y garantiza actualizaciones futuras, asegurando que tu aprendizaje esté siempre al día con las últimas tendencias y tecnologías. Y al completar la ruta, recibirás un certificado que avalará tus conocimientos y habilidades frente a posibles empleadores.

Si estás list@ para entrar en el mundo del Big Data de la mejor manera y convertirte en un experto en Análisis de Datos, explora las opciones de pago y comienza hoy mismo tu formación con Frogames. No dejes pasar la oportunidad de aprender de los mejores y sumérgete de lleno en la especialización que elijas. ¡Tu futuro como Data Scientist te espera!